在本视频中您将了解如何实现正则化逻辑回归。正如线性回归的梯度更新算法与逻辑回归的梯度更新算法看似惊人的相似,您会发现正则化逻辑回归的梯度更新算法也与正则化线性回归的更新公式高度相似。让我们一起来仔细看看。

没错,原理核心是相同的。我们之前了解到当使用像这样的高阶多项式特征进行拟合时逻辑回归容易过拟合,这里的z是一个高阶多项式被传递给simmon函数以计算f值。具体来说这样可能导致决策边界过于复杂,出现过拟合现象,缺乏对训练级的泛化能力。

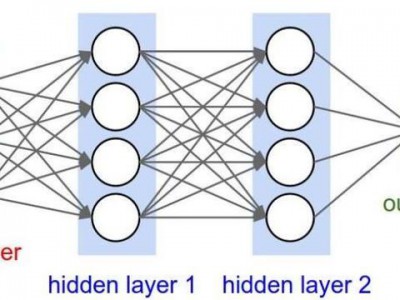

更广泛的说当你使用大量特征训练逻辑回归模型时,无论是多项式特征还是一些其他特征都可能存在较高的过拟合风险。这是logistic回归的成本函数,如果要通过加入正则化来改进它,你只需要向其中添加以下项即可。

让我们在正则化参数中添加lambe两米乘以从这等于一到n的总和,n通常是特征数量及w下划限制的平方和。当你将其作为w和b的函数进行最小化时,这会惩罚参数w1、w2直到wn防止它们变得过大。

如果这样做即使你使用大量多项式进行高阶多项式拟合依然能得到类似这样的决策边界,这种边界看起来能更合理的分离正负样本,同时也有望较好的泛化到新样本不再训练集中。

因此即使特征很多使用正则化时如何实际实现这一点?如何才能真正最小化包含正则画像的代价函数j、w、b?所以我们像之前一样使用梯度下降,你只需要设定要最小化的代价函数并按之前的步骤实现梯度下降即可。

以下是对w、j和b进行同步更新的常规规则,这与正泽化线性回归的做法一致。当计算这些偏导数项时唯一的变化是在对w、j的导数中额外增加了这一项,即末尾加上lamdam乘以w、j。再次说明这与正泽化线性回归的更新规则非常相似,实际上这与之前的方程完全相同。

除了现在f的定义不再是应用于z的线性函数,而是应用于z的逻辑函数,与线性回归类似,只对参数WJ进行正则化,而不会正则化参数B,这便是为什么对B的更新规则不会有变化。

在本周最后的可选实验中,您将重新探讨过拟合问题,并在可选实验的交互式图表中,现在可以通过选择LAN值,在梯度下降过程中启用正则化,从而对回归模型和分类模型进行正则化调整。请特别注意查看实现正则化逻辑回归的代码,因为您将在本周的实践实验中亲自实现这一算法。至此,您已掌握了如何实现正则化逻辑回归。

当我在硅谷行走时,有许多工程师正使用机器学习创造巨大的价值,有时能为公司带来丰厚的利润。虽然你才刚开始学习这几周时间,但只要理解并掌握线性回归和普通回归模型,你已具备构建高价值应用的坚实基础。虽然具体算法工具很重要,但掌握如何降低过你和这样的实物技巧才是业界最珍贵的能力之一。

在此祝贺你迄今为止取得的进步,也要为你坚持看完本视频喝彩。希望你能继续完成配套实验与测验练习,学无止境,更多精彩内容在前方等待。