阿里巴巴集团通义实验室提出的 OmniTalker,这是一个能从文本联合生成语音和会说话视频的统一框架,解决了现有方法的诸多问题。

背景与目的:

近年来,说话头像生成(THG)发展显著,但文本驱动的说话头像研究不足。现有方法多采用级联管道,存在系统复杂、延迟高、音视频不同步和风格差异等问题。

OmniTalker 旨在解决这些问题,在实时零样本场景下从文本和参考视频同时生成同步语音和说话头像视频,并保留语音和面部风格。

方法

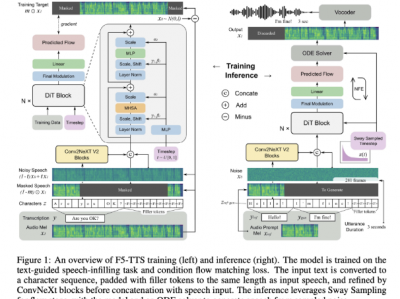

统一多模态框架:在单个模型中集成文本到音频和文本到视频生成,通过跨模态融合实现同步输出。

上下文多模态风格复制:参考引导机制捕捉语音和面部风格,进行零样本复制。

实时效率:集成流匹配并保持较小模型规模(0.8B),在保持高保真输出的同时实现实时推理。

效果

零样本上下文多模态生成:展示了多种中文和英文文本输入生成的示例,体现了该框架在不同语言下的生成能力

情感表达生成:基于不同情感的提示视频,能生成具有相应情感的结果,面部表情丰富,头部姿势自然

长期生成:可以生成长期视频,并保持一致的语气和说话风格

交互式演示:该方法能以 25FPS 的速度实时生成,为交互式视频聊天应用提供了实际支持

最后看看视频效果

https://www.toutiao.com/video/7493174908508291620/ 雷军are u ok?

https://www.toutiao.com/video/7493176804040065570/ 邓丽君

https://www.toutiao.com/video/7493177677122257423/ Trump

直接发不上来