人工智能热潮下的冷思考

安全保密如何不掉队?

专家之声

安全保密全新栏目——

专家之声

从AlphaGo到ChatGPT再到DeepSeek,人工智能展现出足以撼动世界的惊人潜力,也预示着一个全新时代的到来。

人工智能的核心优势在于其强大的数据处理与分析能力,能提升政务效率、推动教育个性化、优化商业决策,在网络安全领域,还能助力威胁情报分析等工作,推动安全保密智能化。但人工智能开源及广泛应用也带来新风险,它既能防御也可能被用于攻击,既能挖掘信息也可能被窃密,还存在隐私泄露等风险。

黑客通过虚假AI网站传播新型窃密木马

如何利用好人工智能这把“双刃剑”,让其在安全可控轨道运行,释放价值,推动社会进步成为当下难题。

揭秘人工智能背后的“超级大脑”

1 深度学习:从模仿到创造

人工智能的核心技术是深度学习,它模仿人脑神经网络的结构,通过构建由多层“神经元(实际上是数学模型)组成的网络来处理信息。这些“神经元”之间的连接强度即“权重”,决定了信号如何传递,而模型学到的所有知识都蕴含在这些权重中。深度学习模型通过接收大量数据,并利用算法不断调整权重,逐渐学会执行特定任务,如图像识别或语言理解,这个过程如同教孩子学习,通过不断地“看”和“听”来积累知识。

2 神经网络:从听课到解题

如果深度学习是构建智慧的基石,那么神经网络就是学生从听课到解题的学习过程。在这一过程中,学生先用“感官”(输入层)接受知识,这些知识传入“大脑”(隐藏层),“大脑”中多个“思考小组”(节点)基于已有经验(权重)分析讨论,层层深入理解。最后面对问题,学生通过“大脑”的“输出口”(输出层)给出答案。神经网络通过这条学习之路,最终将零散知识转化为解题能力。

3 数据驱动:喂养人工智能的“食物”

深度学习模型就像一个嗷嗷待哺的婴儿,需要大量的“食物”才能茁壮成长。这些“食物“就是各种各样的数据,比如图片、文字、声音等等。数据越多、越优质,模型就能学到越多的知识,变得越聪明。就像婴儿需要均衡的营养才能健康成长一样,高质量的数据能让人工智能模型更准确地理解世界,而海量的数据则能让它更灵活地应对各种情况。所以,想要培养出一个“厉害的”人工智能,就要给它提供充足、优质的“食物 ”。

AI带来的安全保密新威胁

人工智能的崛起无疑带来了新一轮技术革命,它强大的功能、广泛的应用以及开源的本质,也同样给安全保密带来了新的风险。

01

数据泄露新风险

人工智能的应用离不开海量数据的支撑,这些数据的采集、清洗、标注、向量化等复杂工序,每个环节都可能成为安全保密短板。

一是原始数据采集风险

人工智能工具对任何数据“来者不拒”。以金融行业数据为例,在信贷审批流程中,金融机构会收集大量企业的财务报表用于评估贷款风险,即便原始数据在采集中采用加密措施,模型参数也可能通过记忆机制存储数据特征,一旦这些数据特征被捕捉并存储,就可能会在一次不经意的“提问”中将敏感信息“回答”出来,成为泄密的“定时炸弹”。

二是开源数据的关联风险

人工智能对数据的“消化”能力远超想象,即使是看似无关紧要的公开信息,在其强大的分析能力面前,也可能被抽丝剥茧,推断出敏感甚至涉密信息。这种“拼图式泄密 ”往往具有很强的隐蔽性,使得原本合规的开放数据经过模型“化学合成”后,产生远超预期的信息泄露风险。

内容生成风险

02

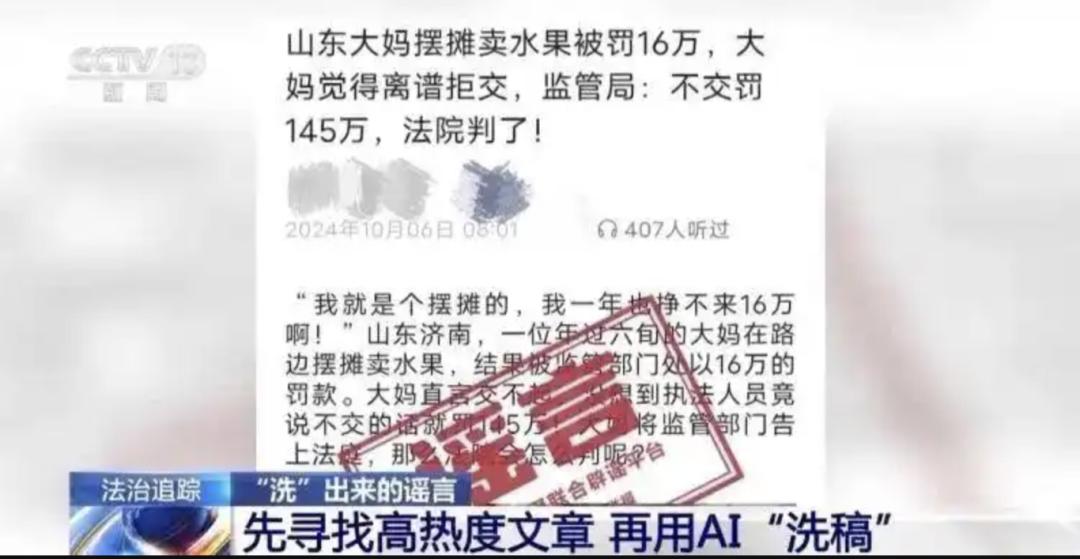

人工智能强大的文本生成能力,赋予了它创造的“魔力”。但这股“魔力”一旦失控,就有可能生成虚假信息、侵犯知识产权等。

眼下,人工智能可生成足以乱真的文本、图像甚至视频。在实际操作中,模型生成内容优先保证语义通顺,为保持叙述的流畅性,人工智能工具会自动补全未经核实的内容,这就为别有用心者编造虚假新闻、伪造文件,或炮制违背社会价值观、危害社会稳定的内容提供了条件和土壤。

与此同时,人工智能的“创作”不受约束,模型可能无意识复制训练数据中的受保护内容,侵犯知识产权、剽窃学术成果。比如,模型在根据用户需要生成学术论文时,会在高度相似的已发表文献中“提炼”相关内容,这种“无意识剽窃”就给学术诚信体系带来了巨大挑战。

03

代码开源风险

人工智能工具的开源特性,在促进技术进步的同时,也可能导致技术滥用或被恶意利用,使其成为“失控地带”。

一是模型参数泄露风险

人工智能模型的开源,如同将其“大脑”暴露于光天化日之下,攻击者可利用其公开架构、参数等,进行模型反推、逆向攻击,还原敏感信息。

二是模型不可解释风险

人工智能算法模型的“黑箱”特性可能导致决策过程不可解释、潜在偏见难以追溯。比如,在医疗诊断场景中,若模型错误推荐了治疗方案而又无法追溯逻辑依据,就可能引发误诊且难追责。

AI保密新风险的应对措施

人工智能技术的迅猛发展正重塑安全保密的边界,其大模型在释放生产力的同时,数据吞噬能力、内容创造野性与开源技术生态,已然构成隐蔽性更强、复杂性更高、破坏力更深的新型威胁。面对这场“静默的革命”,亟须构建制度、技术、监督、培训四位一体的风险防范体系,在创新与安全的动态平衡中筑牢安全保密防线。

01 完善数据安全制度

一是制定严格的数据分类与分级标准,确定哪些数据可用于大模型训练,并明确不同级别数据的处理流程与权限,防止未经授权的数据访问和使用。

二是建立规范的脱敏技术标准,确保所有输入人工智能大模型的数据都经过严格的处理,在数据采集阶段就对敏感信息脱敏并注入噪声,在数据向量化过程中叠加不可逆的噪声扰动,使敏感信息在模型训练时形成“信息熵衰减”。

三是建立全面的人工智能安全审查流程,明确审查标准、方法与责任,确保相关单位和组织对人工智能的使用经过严格规范与审查,并建立数据关联分析机制,评估数据间的潜在联系和泄露隐患,防范数据投喂引发的次生风险。

02 强化安全防护技术

一是加强数据与接口安全管理,研发自动化审查工具,检测输入数据和生成结果的敏感性加强应用程序编程接口(API)的认证与授权,定期进行安全审计,并采取必要的技术监管措施,及时发现和阻止异常行为。

二是加固运行环境与模型,采用安全容器、沙箱等技术隔离运行环境,防止攻击,同时研究对抗样本防御技术,研发具有“参数迷雾”特性的神经网络,防止参数泄露。

三是提升模型决策过程的解释性和透明度,构建跨机构数据投毒免疫系统,通过联邦学习技术实现分布式协同检测,提升模型在复杂环境下的鲁棒性和可信度。四是建立动态安全防护机制,定期对人工智能大模型的应用进行安全风险评估,识别潜在威胁,并建立威胁情报共享机制,确保各参与方及时获取和共享相关安全漏洞及攻击手段等信息,形成协同防御能力,持续提升大模型的安全防护水平。

03 加强监督检查管理

一是建立常态化监督机制,将大语言模型的使用纳入安全保密检查范围,定期开展专项检查、确保使用过程规范。

二是研发大模型保密检查工具,实现敏感信息识别、对抗样本检测、模型行为审计、风险评估与预警以及合规性检查等功能,全面检测和防范潜在风险。

三是强化事后追溯与整改,通过记录模型输入输出、运行日志及参数变化,为事后追溯提供依据,并针对发现的问题及时整改,确保大模型应用的安全性和合规性。

04 健全教育培训体系

一是将人工智能安全保密教育纳入教育培训范畴,并定期通报人工智能领域最新风险动态,持续强化各领域和各级人员的防范意识与能力。

二是开展针对性培训与演练,帮助涉密人员了解人工智能的安全风险并掌握安全使用方法,设立国家级人工智能安全攻防靶场,定期开展“红蓝对抗”演练,提升风险防范和应急处置能力。

原标题:《人工智能热潮下的冷思考,安全保密如何不掉队?》