(来源:定位与商业模式研究)

2025年7月,上海世界人工智能大会(WAIC)如期举行。

本次大会最重要的嘉宾,诺贝尔奖、图灵奖双料得主,“AI教父”杰弗里·辛顿(Geoffrey Hinton)教授不顾旅途劳顿,亲临大会现场,发表重要演讲。

辛顿的演讲并无艰涩的技术术语,只有直击灵魂的哲学思辨。他用了一个生动的比喻来形容当前AI的发展:“养一只老虎当宠物”。他警告世界:人类正在创造比自己更聪明的AI,而指望到时候能轻易“关掉它”是不现实的。

他建议各国共同研究让AI安全可控,而如何训练比人类更聪明且对人类始终友善的“好AI”,将是一个长期的难题。

辛顿的发言,将“AI安全”(AI Safety)这个议题再次推至聚光灯下。而本届WAIC大会的核心主题“Make Safe AI”(创造安全的AI),正是对这一全球性关切的深刻回应。

一、“Make Safe AI”与“Make AI Safe”:治洪哲学的启示

大语言模型(LLM)是本轮人工智能爆发的先锋。在新事物诞生之时,技术不断演化,法律法规完全没有跟上,向其提出“善良”这样没有明确定义的要求是不切实际的。但这项技术展示出的强大能力,让一群科学家和社会学家坐立不安,于是在2023年就出现了包括马斯克在内的一大群全球名人联合签名呼吁暂停发展六个月的事情,当然他们并未如愿。

美国的科技公司,在AI赛道上发力狂奔,也没忘记投入了资金让AI变得安全,英文“Make AI Safe” ,其隐喻是治洪理念中的“堵”。 它预设AI本身是“危险的”,需要通过外部的、事后的、强制性的手段来约束和修正。这如同古代治水,采用“堵”的策略——筑堤、设障、封堵漏洞。在AI领域,这表现为:严格的监管审批、事后的模型审计、对特定功能的禁用(如深度伪造技术)、以及在系统出现偏差后进行人工干预和“打补丁”。这种方法看似直接,但存在明显局限:一是反应滞后,往往在问题发生后才介入;二是成本高昂,需持续投入监控与修正资源。由于大模型系统涉及的信息量极其庞大,人类早已无法穷尽其漏洞数量,因此从理论上来说,这种方法是无效的。

本次上海大会提出要创造原生安全的人工智能,英文“Make Safe AI”,其核心是“疏”。它强调在AI系统的“设计之初”就将安全性作为核心属性内嵌其中,如同大禹治水,顺应水势,引导其流向,变害为利。这要求我们从源头思考:如何设计AI的目标函数使其与人类价值观对齐?如何构建透明、可解释的架构以便人类理解其决策过程?如何赋予AI“谦逊”(epistemic humility)的特性,使其在不确定时主动求助而非强行决策?

举一个已经深入网民生活各个领域的例子:内容推荐算法。

“Make AI Safe”(堵):平台发现算法推送了大量煽动性、虚假或极端化内容,引发社会争议。监管机构介入,要求平台“整改”,增加人工审核团队,对特定话题进行限流。这是典型的“堵漏洞”。在全球范围内,这种算法上的有意无意设计,曾经造成了数百万人丧命的宗教与种族冲突,但Facebook至今并未堵上这种漏洞。“Make Safe AI”(疏):平台在算法设计时,就将“用户福祉”、“信息多样性”、“长期社会价值”等多维目标纳入优化函数,而不仅仅是“点击率”或“停留时长”。算法被设计为能主动识别“信息茧房”形成趋势,并主动引入异质信息进行“破茧”。安全性和价值导向从一开始就是算法的“基因”。我们认为,“疏”优于“堵”,不仅在于效率,更在于其系统性、前瞻性和可持续性。WAIC提出“Make Safe AI”,正是倡导从“被动防御”转向“主动塑造”,从“问题治理”转向“源头设计”。

二、挑战与路径:通往“安全AI”的荆棘之路

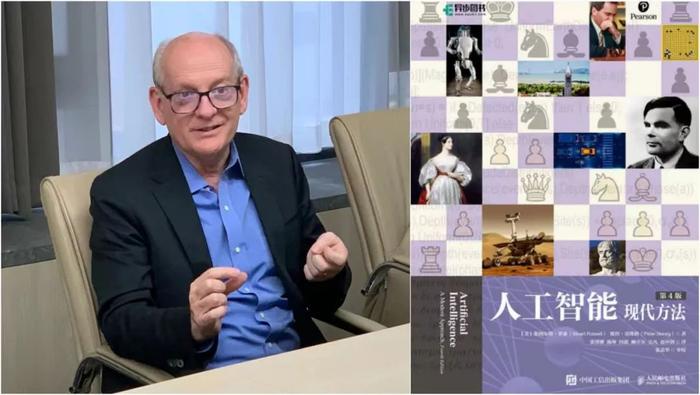

另一位参加本次上海WAIC大会的重量级嘉宾,斯图尔特·罗素(Stuart Russell),是全球人工智能领域最有影响力的权威人士之一。他不仅是人工智能领域标准教材的作者,更是联合霍金等科学家发表了署名文章号召大家警惕人工智能可能给人类带来威胁。

他在《AI新生》(Human Compatible)一书中,仿照科幻巨匠阿西莫夫的“机器人三原则”,提出了“有益AI”的三条原则:

1.机器的唯一目标是最大限度地实现人类的偏好。

2.机器最初不确定这些偏好是什么。

3.关于人类偏好的最终信息来源是人类行为。

他在6年前出版这一本书时,本轮大模型技术还没有爆发。但专注于前沿领域的科学家早已看到未来,因此他在书中提出的问题与解决方案,与本次大会的主题不谋而合。

尽管“Make Safe AI”的理念非常重要,但将其付诸实践,我们不得不面临巨大挑战。

挑战一:对齐难题(Alignment Problem)。如何将复杂、模糊、动态的人类价值观精确地“编码”进AI的目标函数?人类的价值观本身充满矛盾(如自由 vs 安全,效率 vs 公平),且随文化、情境而变。一个为“最大化用户参与度”而优化的AI,可能无意中放大了偏见、焦虑或成瘾行为。解决之道包括可扩展的监督(Scalable Oversight)和递归评估(Recursive Evaluation)技术等,让AI系统能自我评估其行为的伦理影响,或利用更强大的AI来监督和指导较弱AI的安全性。

挑战二:黑箱困境(Black Box Problem)。深度学习网络的决策过程如同“黑箱”,人类难以解释。这使得“内建安全”变得困难,因为我们无法确知AI为何做出某个决定,也就难以确保其内在逻辑是安全的。突破方向是可解释AI(XAI)和形式化验证(Formal Verification)。前者致力于开发能清晰展示AI决策依据的工具(如注意力机制可视化、反事实解释);后者则尝试用数学方法证明AI系统在特定条件下必然满足安全属性(如“永不建议用户进行危险行为”)。

挑战三:能力与安全的权衡(Capability-Safety Trade-off)。追求极致性能的AI往往结构复杂,增加了安全控制的难度;而过度强调安全,又可能牺牲AI的效率和创新潜力。这需要在工程上实现精妙的平衡。一种思路是分层架构(Layered Architecture):核心决策层追求鲁棒与可解释,外围执行层可追求高性能,但受核心层的严格约束。同时,发展安全沙盒(Safety Sandbox) 和渐进式部署(Gradual Deployment) 策略,在可控环境中充分测试AI的安全边界。

挑战四:动态演化风险(Dynamic Emergent Risks)。AI系统,尤其是具备学习和适应能力的系统,其行为可能在部署后随环境变化而“涌现”出设计者未曾预料的模式,甚至出现“目标错位”。应对之策包括:持续监控与反馈循环,建立实时安全指标;内置“关机开关”或“紧急制动”机制(尽管其可靠性存疑);以及最重要的,人类在环(Human-in-the-Loop) 设计,确保关键决策始终有人类的最终监督和否决权。

三、上海共识:安全与发展的东方平衡术

当前AI监管呈现三足鼎立:欧盟立法先行但反应迟缓,美国依赖企业自律,中国推行"敏捷治理"试点。这种碎片化局面使得跨国科技巨头常游走于监管真空地带。

本届WAIC的成果之一是辛顿、姚期智等专家联名签署“上海共识”,呼吁为 AI 划下“行为红线”。这份被称作"数字时代的核不扩散条约"的文件,直指一个残酷现实:AI能力已接近或超越人类,但我们仍缺乏有效控制手段。共识强调:人工智能的发展应以人类福祉为最高准则,坚持安全可控、公平包容、开放协作的原则。鼓励“Make Safe AI”的研发范式,将安全、可信、负责任的理念贯穿于人工智能全生命周期。

“上海共识”的提出,不仅是一份技术治理的倡议,更折射出中国在AI发展路径上的深层思考与战略选择。相较于美国政府最近宣布的AI发展计划中“不计一切代价,加速发展”(Move fast and break things)的激进路线,中国展现出一种更具审慎与长远视野的“行稳致远”模式。

美国模式以技术创新和商业竞争为首要驱动力,追求在AGI等前沿领域的绝对领先地位。其优势在于创新活力强、迭代速度快,但潜在风险被置于次要位置,监管滞后于技术发展,易引发“技术失控”的担忧。

中国模式则更加强调“发展”与“安全”的辩证统一。从《新一代人工智能伦理规范》到《生成式人工智能服务管理暂行办法》,再到WAIC倡导的“Make Safe AI”,一以贯之的逻辑是:安全是发展的前提,发展是安全的保障。这种“疏堵结合,以疏为主”的治理智慧,既鼓励技术创新,又通过前瞻性的制度设计和标准引领,为技术狂奔系上“安全带”。

当前AI的爆发式发展与一大堆复杂的因素不期而遇,诸如经济失衡、地缘政治、技术突破、地球变暖、局部战争、等等。人工智能的安全虽然足以影响人类文明的未来,但在当下似乎并非什么紧急的大事。

让我们放松心态,以科幻式的方式来思考一下。你认为谁在走阳关道,谁在走独木桥呢?