深度神经网络中,梯度消失问题较为常见且棘手。该问题致使网络训练效率低下,甚至可能出现完全无法学习的情况。梯度消失主要出现在基于梯度的学习算法里,尤其在深层网络中更为明显。本文将深入探讨梯度消失的成因及多种有效的应对策略。

通常,梯度消失问题由以下几方面因素导致:

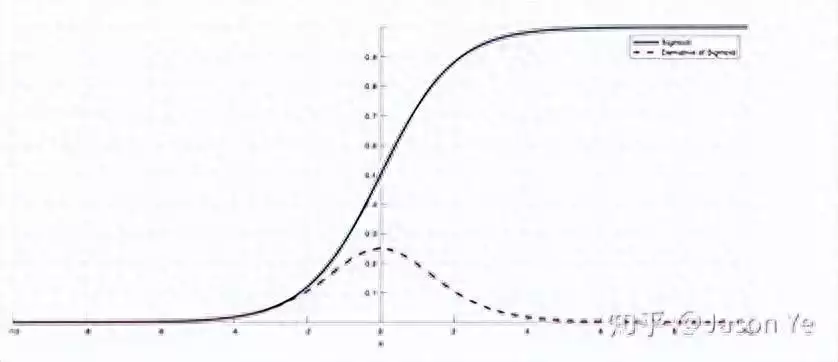

深层网络结构:在深层网络环境下,梯度借助反向传播算法从输出层向输入层传递。由于连乘效应,若梯度值小于1,其在传播过程中会快速衰减至接近零,进而使得前面层的权重更新极为缓慢,甚至停滞不前。 激活函数的选择:像Sigmoid或Tanh这类饱和激活函数的使用会引发梯度消失问题。这些函数的导数在输入值较大或较小时趋近于零,从而在多层网络中导致梯度迅速衰减。 权重初始化:不恰当的权重初始化方式也可能造成梯度消失。比如,如果权重初始化得太小,那么在反向传播过程中,梯度会因连乘效应而变得极小。为有效解决梯度消失问题,研究者们提出了多种方法:

改进激活函数:ReLU(Rectified Linear Unit)及其变种,如Leaky ReLU和Parametric ReLU,已被证实在防止梯度消失方面成效显著。ReLU的导数在正区间保持恒定,有助于缓解梯度消失问题。 权重初始化技术:合适的权重初始化能够减轻梯度消失问题。例如,专为ReLU激活函数设计的He初始化和Glorot初始化,能在训练开始时维持梯度的规模。 批量归一化(Batch Normalization):批量归一化通过对每一层的输入进行规范化处理,使其均值为0,方差为1,有助于缓解梯度消失问题,因为它确保了网络中每层的激活分布保持一致。 残差网络(Residual Networks, ResNets):残差网络通过引入跳跃连接(skip connections),使梯度能够直接流向更深的层,从而减轻了梯度消失问题。 梯度剪切(Gradient Clipping):在训练进程中,若检测到梯度超过某个阈值,便将其剪切至一个最大值。这既能防止梯度爆炸,又能间接缓解梯度消失问题。 使用LSTM或GRU结构:在循环神经网络中,长短期记忆(LSTM)和门控循环单元(GRU)借助门控机制来规避梯度消失问题。 预训练加微调(Pre-training and Fine-tuning):先通过无监督的方式预训练每一层,再运用监督学习对整个网络进行微调,可有效初始化网络权重,减少梯度消失问题。