大家好,今天我们来聊一聊深度学习中的一个重要概念——卷积神经网络(Convolutional Neural Networks,简称CNN)。无论你是程序员、数据科学家,还是对人工智能感兴趣的朋友,相信读完这篇文章后,你都能对CNN有一个清晰的认识。

一、卷积神经网络是什么?

卷积神经网络(CNN)是深度学习领域中的一种重要算法,尤其在计算机视觉任务中表现出色。简单来说,CNN是一种专为处理网格结构数据(如图像)设计的神经网络模型。它的灵感来源于生物学中的视觉皮层结构,通过局部感知野(receptive field)来捕捉图像中的局部特征,然后逐层组合以提取更高级的特征。

二、为什么需要卷积神经网络?

在传统的全连接神经网络(Fully Connected Neural Networks)中,每个神经元都与前一层的所有神经元相连。对于图像这种高维数据来说,这种连接方式会导致参数量巨大,计算复杂度极高,且容易出现过拟合。而CNN通过局部连接和权值共享的方式,大幅减少了参数量和计算复杂度,同时提高了模型的泛化能力。

三、卷积神经网络的核心组件

一个典型的卷积神经网络主要由以下几个核心组件构成:

1. 输入层(Input Layer)输入层是CNN的第一层,负责接收原始图像数据或其他类型的网格结构数据。这些数据可以是灰度图像、彩色图像、声音信号等。在图像处理中,输入层通常会对图像进行归一化处理,使其像素值落在一个合理的范围内(如0到1之间)。

2. 卷积层(Convolution Layer)卷积层是CNN的核心组件之一,它通过卷积操作来提取输入数据的特征。卷积操作包括在输入图像上应用多个可学习的滤波器(或称卷积核),每个滤波器会产生一个特征图(Feature Map),表示输入图像的不同特征,如边缘、纹理等。

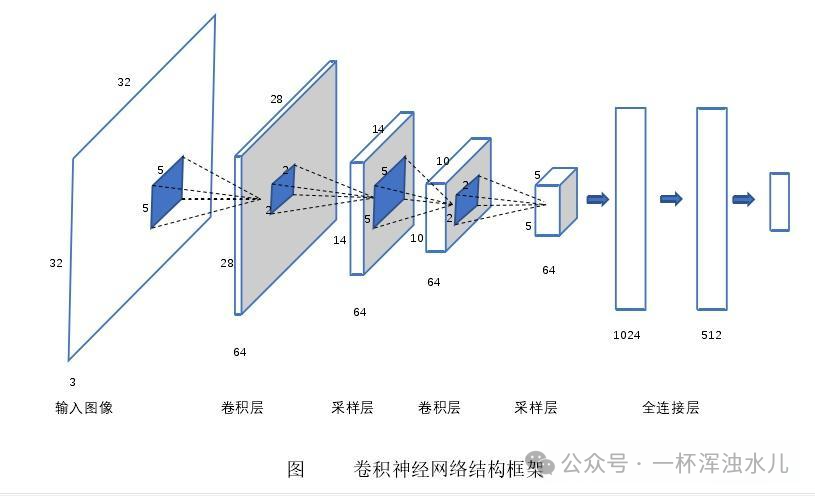

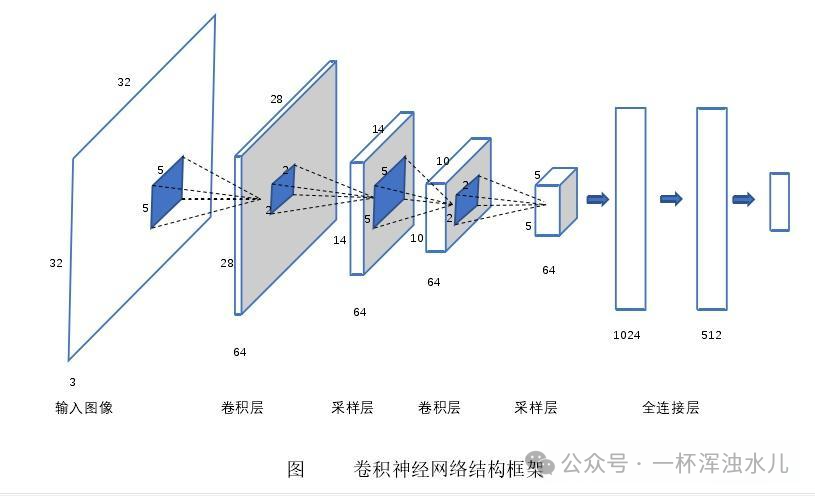

卷积核(Kernel):卷积核是一个小的矩阵,它会在输入图像上滑动,通过卷积运算生成特征图。卷积核的大小(如3x3、5x5)和数量(即滤波器的数量)是CNN设计中的重要超参数。步长(Stride):卷积核在输入图像上滑动的距离。步长越大,输出的特征图尺寸越小。填充(Padding):为了控制输出特征图的尺寸,有时会在输入图像的边缘添加额外的像素(通常为0)。3. 激活函数(Activation Function)卷积层通常会跟随一个非线性的激活函数,如ReLU(Rectified Linear Unit)。激活函数有助于引入非线性,使网络能够学习复杂的模式和特征。4. 池化层(Pooling Layer)池化层通过对特征图进行下采样(如最大池化或平均池化)来减少特征图的尺寸,从而降低计算量,同时保持最重要的特征。池化操作还能增强模型对特征位置的鲁棒性。最大池化(Max Pooling):在池化窗口内取最大值作为输出。平均池化(Average Pooling):在池化窗口内取平均值作为输出。5. 全连接层(Fully Connected Layer)在网络的末端,通常会接一个或多个全连接层。全连接层将提取的特征进行组合,并通过激活函数输出最终的预测结果。全连接层常用于分类任务中,将提取的特征映射到类别标签上。6. 归一化层(Normalization Layer)为了加快网络训练速度并提高稳定性,通常在网络中加入归一化层,如批量归一化(Batch Normalization)。归一化层可以减少内部协变量偏移,使网络更容易训练。四、卷积神经网络的工作流程

卷积神经网络的工作流程通常包括以下几个步骤:输入数据准备:输入的通常是一个图像或多通道的图像数据。CNN会对图像进行归一化处理。特征提取:通过一系列卷积层和激活函数,逐步提取输入图像的特征。早期的卷积层通常提取低级特征(如边缘、纹理),随着网络的加深,后续层会提取更高级别的特征(如形状、物体轮廓)。特征缩减与维度降低:池化层和归一化层会进一步减少特征图的尺寸,同时保留重要的特征信息。特征映射到输出:提取的特征经过全连接层的组合,最终输出分类结果或其他任务的预测结果。五、卷积神经网络的示例

为了更好地理解卷积神经网络的工作原理,我们来看一个具体的示例。假设我们有一张大小为32x32的灰度图像(单通道),我们想要构建一个简单的CNN来进行手写数字识别(如MNIST数据集)。1. 输入层输入层接收这张32x32的灰度图像,将其展开为一个784(32*32)维的向量。但在实际应用中,我们通常会保持图像的空间结构,即输入层的大小为32x32x1。2. 卷积层(CONV1)我们使用6个5x5的卷积核进行卷积操作,步长为1,填充为0。每个卷积核会产生一个特征图,因此输出的大小为(32-5+1)x(32-5+1)=28x28,共有6个特征图,即输出大小为28x28x6。3. 激活函数(ReLU)对卷积层的输出应用ReLU激活函数,增加非线性。4. 池化层(POOL1)对ReLU的输出进行最大池化操作,池化窗口为2x2,步长为2。因此,输出的大小为(28/2)x(28/2)=14x14,通道数保持不变,即输出大小为14x14x6。5. 卷积层(CONV2)我们使用16个5x5的卷积核进行卷积操作,步长为1,填充为0。每个卷积核会产生一个特征图,因此输出的大小为(14-5+1)x(14-5+1)=10x10,共有16个特征图,即输出大小为10x10x16。6. 激活函数(ReLU)对卷积层的输出再次应用ReLU激活函数。7. 池化层(POOL2)对ReLU的输出进行最大池化操作,池化窗口为2x2,步长为2。因此,输出的大小为(10/2)x(10/2)=5x5,通道数保持不变,即输出大小为5x5x16。8. 全连接层(FC1)将池化层的输出展平为一个一维向量,即5x5x16=400维。然后接一个全连接层,假设有120个神经元。9. 激活函数(ReLU)对全连接层的输出应用ReLU激活函数。10. 全连接层(FC2)再接一个全连接层,假设有84个神经元。11. 输出层最后接一个全连接层,输出大小为10(对应0-9这10个数字)。使用softmax激活函数将输出转换为概率分布。六、卷积神经网络的应用场景

卷积神经网络在各类计算机视觉任务中表现出色,包括但不限于:图像分类:如ImageNet大规模视觉识别挑战赛(ILSVRC)中的图像分类任务。目标检测:如R-CNN、YOLO和SSD等算法在图像中定位和识别多个目标物体。图像分割:如U-Net、SegNet等网络架构精确地分割出图像中的各个部分。人脸识别:CNN在面部特征提取方面非常有效,被广泛应用于人脸识别系统中。自然语言处理:尽管CNN主要用于图像处理,它在自然语言处理任务中也得到了成功应用,如文本分类和情感分析。七、结语

卷积神经网络作为深度学习领域的一颗璀璨明珠,已经在计算机视觉、自然语言处理等多个领域取得了巨大的成功。通过本文的介绍,相信你已经对CNN有了初步的认识。未来,随着技术的不断发展,CNN的应用前景将更加广阔。如果你对CNN感兴趣,不妨动手实践一下,相信你会有更深的理解和收获。