AI

刘文杰 | 何以透明,以何透明:人工智能法透明度规则之构建

hqy 发表于2025-02-26 浏览241 评论0

hqy 发表于2025-02-26 浏览241 评论0

作者:刘文杰(中国政法大学比较法学研究院教授,法学博士)

AI

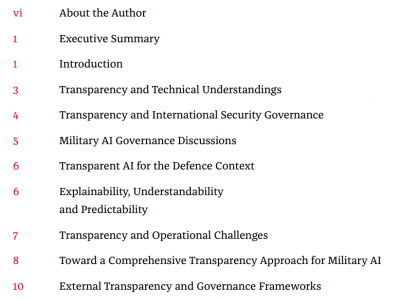

《军事人工智能系统与透明度》最新报告

hqy 发表于2025-02-26 浏览19 评论0

hqy 发表于2025-02-26 浏览19 评论0

有关军事人工智能(AI)系统的国际治理讨论经常强调透明度的必要性。然而,透明度是一个复杂的、多层面的概念,在有关负责任地使用人工智能的国际辩论和文献中,人们对它有不同的理解。它包括可解释性、可解释性、可理解性、可预测性和可靠性等方面。这些方面在国家确保系统透明和负责任的方法中的体现程度仍不明确,需要进一步调查。此外,在军事人工智能应用中实现透明度还面临一些挑战。首先,该技术固有的不透明性会使决策过程难以追踪和理解。其次,军事机构更有可能采取自愿性的透明措施,重点确保操作人员对系统功能有一个总体的了解,而不完全涉及问责的细微差别。此外,各国技术能力的差异表明测试和培训标准参差不齐,使对人的决策和问责的评估更加复杂。最后,鉴于国防和国际安全的敏感性,军事人工智能系统预计将保持高度机密,使外部评估变得困难。本文提出了克服这些挑战的途径,并概述了一个全面透明的框架,这对于在军事环境中负责任地使用人工智能至关重要。

AI

OpenAI 与 FrontierMath 基准测试争议:对人工智能领域透明度与诚信的警示

hqy 发表于2025-02-26 浏览26 评论0

hqy 发表于2025-02-26 浏览26 评论0

OpenAI 与 FrontierMath 基准测试争议:对人工智能领域透明度与诚信的警示

AI

OpenAI开放o3思维链:AI透明化时代的里程碑与背后的争议

hqy 发表于2025-02-26 浏览13 评论0

hqy 发表于2025-02-26 浏览13 评论0

AI

斯坦福AI透明度指数出炉!细数巨头公司的透明度挑战:巨头都不及格 | 科技创新中伦理问题前瞻研究(123)

hqy 发表于2025-02-26 浏览16 评论0

hqy 发表于2025-02-26 浏览16 评论0

点击蓝字

AI

微软发布首份AI透明度报告 展示其人工智能工作发展

hqy 发表于2025-02-26 浏览12 评论0

hqy 发表于2025-02-26 浏览12 评论0

点击蓝字 关注我们

AI

AI透明化,面临着一个悖论

hqy 发表于2025-02-26 浏览34 评论0

hqy 发表于2025-02-26 浏览34 评论0

AI

Open Loop关于人工智能透明度及可解释性报告的解读

hqy 发表于2025-02-26 浏览20 评论0

hqy 发表于2025-02-26 浏览20 评论0

Open Loop是一个全球组织,由Meta(前Facebook)支持,将政府、监管机构、科技公司、学者和社会代表联系起来,旨在通过一系列的实验,创建政策模型,制定人工智能和其他新兴技术的有效发展策略。随着人工智能的不断发展,公众越来越关注人工智能系统的底层架构,以及其运行逻辑,这就涉及到人工智能可解释性(XAI)问题,即人类在何种程度上能够理解人工智能的决策。人工智能模型的可解释性越高,人们对于其决策的可解释度与信赖度就越高。Open Loop围绕人工智能透明度和可解释性的问题,于2020年4月到2021年3月在亚太地区开展研究,提出了相关规范建议,形成了《关于人工智能透明度及可解释性的报告》(AI Transparency & Explainability: A Policy Prototyping Experiment)。

AI

通知 | 国家自然科学基金委员会发布可解释、可通用的下一代人工智能方法重大研究计划2025年度项目指南

hqy 发表于2025-02-26 浏览21 评论0

hqy 发表于2025-02-26 浏览21 评论0

可解释、可通用的下一代 人工智能方法重大研究计划面向人工智能发展国家重大战略需求,以人工智能的基础科学问题为核心,发展人工智能新方法体系,促进我国人工智能基础研究和人才培养,支撑我国在新一轮国际科技竞争中的主导地位。

AI

【E闻日报】“可解释人工智能”实战应用:“光明”电力大模型发布

hqy 发表于2025-02-26 浏览17 评论0

hqy 发表于2025-02-26 浏览17 评论0

12月23日